Ayer se presentó GPT4o (Omni), la versión de GPTChat multimodal, en lo que será la primera gran evolución del GPT para acercarlo al asistente virtual. Un paso muy importante en la relación de las personas con las máquinas.

Con la versión Omni volverán los mismos debates sobre el potencial de la herramienta, sobre la sostenibilidad del uso de los modelos transformer, la privacidad de los datos personales, pero también sobre su capacidad de sustituir a médicos, por ejemplo, o sobre si debemos actuar con responsabilidad en su entrenamiento.

Pero en su uso, que al ser gratis será amplio, nos lanzaremos a buscarle oportunidades, y debemos hacerlo sabiendo que como las cookies, si aceptamos usarlas gratis, lo que estamos aceptando es que estamos entrenando al modelo con nuestros datos personales.

Por eso lo primero que dijo Mira Murati (CTO en OpenAI) en la presentación de ayer – para motivarnos a usarlo – es que esto es, sobre todo, «una herramienta que será un beneficio para toda la humanidad.»

¿Qué aporta nuevo GPT4o?

Entre las capacidades que aporta GPT4o están las siguientes:

- Capacidades Multimodales: Integración no solo de texto, sino también de otras formas de datos como imágenes, audio y video. Esto permitiría a GPT-4 Omni interpretar y generar respuestas basadas en múltiples tipos de información.

- Interacción Avanzada: Mejora en la capacidad de comprender y mantener conversaciones más largas y complejas, posiblemente con mejor manejo del contexto a lo largo de múltiples interacciones.

- Optimización y Eficiencia: Mejoras en la eficiencia del modelo, haciéndolo más rápido y preciso en sus respuestas, además de ser más accesible y utilizable en una variedad más amplia de aplicaciones y dispositivos.

Qué permite esto? Una variedad de cosas, pero lo acerca a algo que ha sonado esta semana… en un asistente. Un asistente con IA, un paso más hacia el futuro.

¿Que implicaciones tiene un asistente virtual con el potencial de GPT4?

La mayor implicación que tendrá un asistente virtual es la necesidad de entrenarlo con datos personales. Nuestra agenda, correos, y mensajes por ejemplo, pero también nuestra voz, y esto implica nuestro timbre, volumen, tono, velocidad, y ritmo, y de alguna manera nuestra personalidad y nuestras emociones.

El hecho de que un asistente virtual tenga acceso a una gran cantidad de información en un contexto determinado y pueda hacer sugerencias resulta interesante. Sin embargo, si con los modelos de lenguaje LLM hemos empezado a ceder nuestro conocimiento, ¿qué estamos entregando con los modelos multimodales?

Con estos nuevos modelos estaremos proporcionando información sobre nuestras vidas pero también sobre nuestras emociones y personalidad. Aunque esto podría ser motivo de profunda reflexión, no parece representar una barrera significativa, considerando cómo hemos interactuado con las redes sociales en las últimas dos décadas. Sin embargo, en el ámbito empresarial, esto plantea un problema considerable, llevando a muchas empresas como Samsung a prohibir el uso de estas herramientas debido al riesgo de filtrar información sensible.

Aunque todavía es pronto para saberlo con certeza, una de las cuestiones cruciales por resolver es cómo OpenAI planea gestionar la información personal para alimentar al modelo Omni. Por ello, debemos explorar con cautela hasta tener una confirmación clara.

El mercado de asistentes virtuales

Una encuesta en línea realizada en mayo de 2017 reveló que los asistentes virtuales más utilizados en los Estados Unidos eran Siri de Apple (34%), Google Assistant (19%), Amazon Alexa (6%) y Microsoft Cortana (4%).

Segun el informe de Mordor Intelligente, «el mercado de asistentes virtuales de IA está segmentado por producto (Chatbot, altavoz inteligente), interfaz de usuario (texto a texto, texto a voz, reconocimiento automático de voz), usuario final (para chatbots (minorista, atención médica, BFSI, telecomunicaciones, Viajes y hotelería), para oradores inteligentes (personal y comercial)) y Geografía. «

» Las redes neuronales profundas, el aprendizaje automático y otros avances en IA están haciendo posibles más asistentes virtuales. Los chatbots y los parlantes inteligentes son dos ejemplos de asistentes virtuales que se utilizan en el comercio minorista, BFSI y la atención médica, entre otras industrias de usuarios finales. «

En el campo de la salud se están adaptando estas tecnologías con gran interés y a gran escala. Por ejemplo, ya existen asistentes virtuales que se centran en la gestión de enfermedades crónicas y responden activamente a las preguntas y solicitudes de los pacientes.

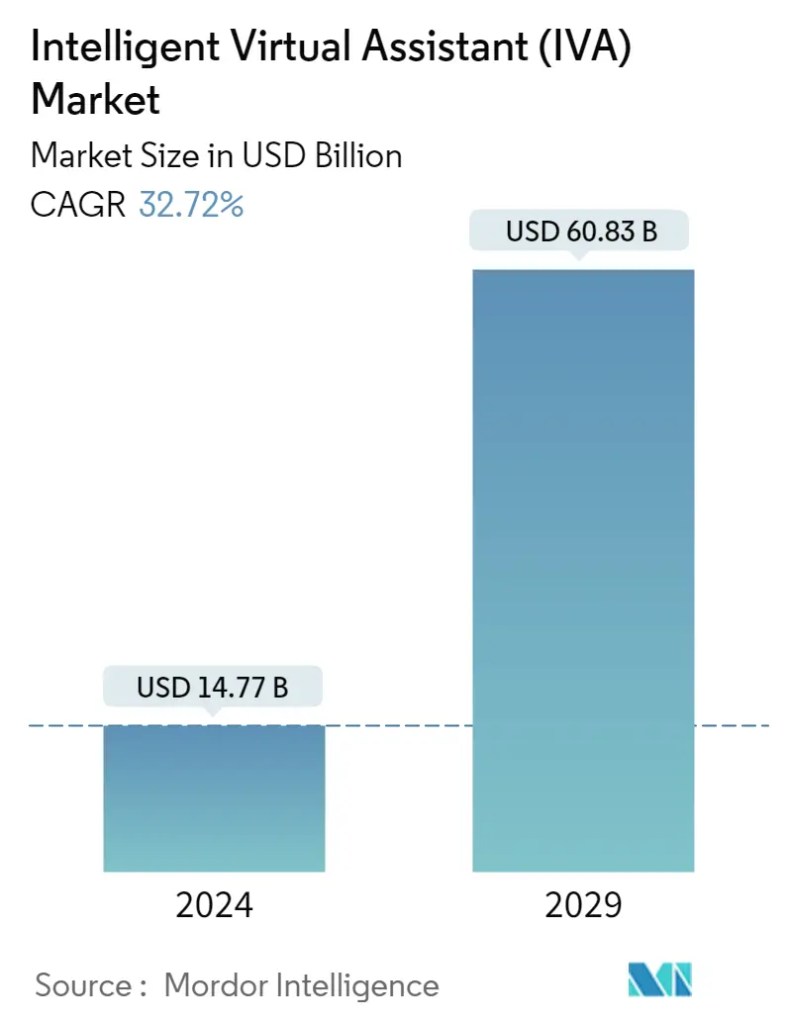

Con respecto al tamaño del mercado, según datos del mismo informe, se espera un crecimiento a una tasa compuesta anual del 32,72%.

Desde la perspectiva del futuro del trabajo, la realidad es que, aunque los modelos de lenguaje ya anunciaban una revolución, los modelos multimodales van un paso más allá y generarán muchas fricciones en ciertos mercados, como el telemarketing, además de abrir la puerta a interesantes debates.

Estos debates nos llevarán a explorar temas como la sustitución de personas por asistentes virtuales, el uso de estas tecnologías en sectores en los que la interacción humana es tan importante como la medicina, la utilización de datos médicos y personales para entrenar los modelos, y la responsabilidad por los errores cometidos por las máquinas, que al final recaerán en personas. Todo esto, además, sin abordar las cuestiones de sostenibilidad de los modelos transformer que funcionan gracias al uso masivo de datos.

Como mencionaba el artículo de McKinsey en 2020, «Technology and Innovation: Building the Superhuman Agent,» las nuevas herramientas emergentes tienen el potencial de transformar el desempeño de los agentes en los centros de contacto, y ahora, con el lanzamiento de GPT4o se abre un mundo de riesgos y oportunidades.

Riesgos y oportunidades

Como hemos visto los asistentes virtuales multimodales, como GPT4o (Omni), presentan una serie de riesgos y oportunidades en relación con el empleo, la privacidad y la ética.

En relación al Empleo, aumentará la productividad y se crearán nuevos roles, en el caso de los contact center y los centros de telemarketing mejorarán con casi total seguridad la eficiencia y la satisfacción de los clientes, y habrá, como consecuencia de la automatización de estas tareas, una reducción de los puestos de trabajo y sobre todo, obligará a gran parte de estas personas a pasar por un proceso de capacitación para adaptarse a las nuevas tecnologías.

Con respecto a la privacidad de los datos, los asistentes virtuales pueden, con la tecnología adecuada, gestionar grandes volúmenes de datos de manera eficiente y segura, personalizar servicios, y servir de gran ayuda en el proceso de automatización, pero los riesgos son obvios, ya que la vulnerabilidad de los datos, los riesgos de brechas de seguridad, y el mal uso que puedan hacerse de esos datos, especialmente para el marketing sin consentimiento, hay que tenerlos en cuenta y minimizarlos.

Con respecto a la ética se abren muchos frentes, desde la propia transparencia de cómo funcionan estos asistentes virtuales, como también vigilar que no generen discriminación ni sesgos, y sobre todo, determinar quien es responsable de las decisiones tomadas por un asistente virtual.

En fin, OpenAI con su GPT4o abre la puerta a un gran potencial para transformar diversas áreas, pero también plantean importantes desafíos que deben ser gestionados con cuidado para maximizar sus beneficios y minimizar sus riesgos, para como bien dijo Murati, beneficiar a toda la humanidad.